A través de simulaciones en supercomputadoras explican propiedades de las galaxias

Parte del estudio, en el que participa Héctor Manuel Velázquez, fue publicado en The Astrophysical Journal; el académico de la UNAM implementó una estrategia que reduce las fuentes de error

Las propiedades de las galaxias son resultado de complicados procesos entre el gas, polvo, radiación, estrellas y las propiedades del universo en su conjunto. Interpretar las observaciones de galaxias de forma detallada requiere considerar tal complejidad, por lo general utilizando supercomputadoras.

En años recientes se ha logrado un impresionante avance en este tipo de simulaciones, pero aún hay varios retos para este enfoque.

Observaciones hechas hace poco por el telescopio espacial James Webb muestran posible evidencia de galaxias bien desarrolladas muy al inicio de la evolución del universo, en aparente conflicto con los cálculos teóricos.

Otro reto descubierto desde finales de los 90 es la aparente falta de galaxias satélites brillantes alrededor de la Vía Láctea u otras galaxias similares; ya algunas simulaciones proporcionaban posibles explicaciones, pero otras no.

Por último, se sabe que una parte importante de los átomos (bariones) se encuentran en el halo de las galaxias circundando el disco; predicciones detalladas de las propiedades de este gas han sido una tarea pendiente.

Una dificultad a la que los astrofísicos se enfrentan para explicar cómo se formaron las galaxias desde el Big Bang hasta la actualidad, consiste en las fuentes de incertidumbre relacionadas de los códigos computacionales con los que se simula la formación de las estrellas, sus explosiones, así como el movimiento del gas, la materia oscura y las estrellas mismas.

En ocasiones, sólo ciertos grupos parecen poder capturar algunos de los fenómenos mientras que otros no; sin embargo, uno internacional de científicos, en el que colabora Héctor Manuel Velázquez, investigador del Instituto de Astronomía (IA) de la UNAM, ha implementado una estrategia para reducir las fuentes de error de las simulaciones.

La colaboración internacional AGORA (Assembling Galaxies Of Resolved Anatomy) tiene como objetivo realizar un proyecto de comparación entre los códigos más importantes para seguir la formación de galaxias dentro de la estructura a gran escala del universo, mencionó Héctor Manuel Velázquez, único científico mexicano que participa en el proyecto y quien realizó varias de las simulaciones.

“AGORA nos ha ayudado a mejorar los códigos numéricos al encontrar y corregir errores y comprender mejor cómo los parámetros en cada código controlan los procesos astrofísicos, incluida la formación de estrellas. Éste es el punto de partida para simulaciones cada vez más precisas de la formación de galaxias que realmente nos ayuden a interpretar de manera confiable las observaciones”, afirma Héctor Manuel Velázquez.

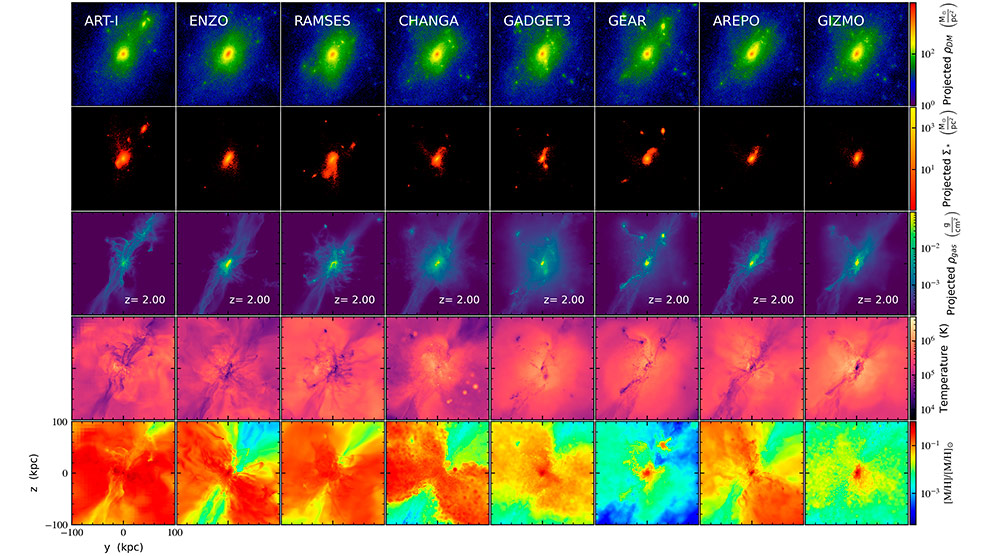

Para realizar reproducciones más realistas se compararon los resultados de los códigos más utilizados en el mundo (AREPO, GADGET, ART, RAMSES, CHANGA, GIZMO, entre otros), partiendo de las mismas condiciones iniciales y un modelo igual de formación estelar, dejando libres otros aspectos tanto de la física como numéricos.

Lo anterior permitió cuantificar y valorar en qué condiciones se logran resultados similares o convergentes entre todos los grupos. “Este esfuerzo permitirá separar los sesgos asociados a cada código computacional utilizado en la interpretación de las observaciones de las galaxias”, agregó Octavio Valenzuela Tijerino, coordinador del Laboratorio de Modelos y Datos de la UNAM.

Las comparaciones realizadas se basan en códigos de computadora, que cada comunidad ha desarrollado para seguir la formación y evolución de galaxias: “tenemos diferentes programas con distintas estrategias para representar las cantidades físicas, por ejemplo, mallas que son como un cuadriculado donde se va resolviendo la física del problema; dichas mallas pueden enfocarse de forma automática en ciertas regiones y aumentar la resolución en esa región para seguir con más detalle el proceso de evolución. En algunos casos no son un cuadriculado, sino más bien un mapa de mosaicos triangulares para adaptarse fácilmente a la forma de los objetos simulados. Además, hay otros programas basados en partículas o aquellos que usan tanto mallas como partículas. Cada uno tiene sus bondades, limitaciones y ventajas”, comentó a su vez Héctor Manuel Velázquez.

¿Cuáles son las limitantes?

Algunas limitantes se dan en la resolución, precisión numérica o la cantidad de memoria o tiempo de procesador que requieren, así como por hipótesis sobre una variedad de factores físicos, como la evolución y explosión de las estrellas, los flujos de gas en las galaxias, además de los movimientos estelares o de la materia oscura.

Los cientos de simulaciones han implicado esfuerzos computacionales muy grandes que significaron millones de horas de tiempo de cómputo y acceso a grandes recursos de almacenamiento: “Lo más complicado fue conseguir los recursos de supercómputo”, añadió Velázquez.

Por otro lado, el recurso humano es vital para lograr los resultados obtenidos, por ello, la colaboración está integrada por tantos investigadores; sin embargo, hay pocos científicos y estudiantes involucrados en estos estudios en nuestro país: “La contribución de México a la realización y calibración de estas simulaciones que ayudan a consolidar el entendimiento de fenómenos en las galaxias sería mayor si hubiera más personas, en especial jóvenes, trabajando en este tipo de proyectos”, puntualizó Valenzuela Tijerino.

Asimismo, ambos investigadores reconocieron que, aunque podría pensarse que en México es difícil participar en este tipo de esfuerzos debido a la gran cantidad de recursos de cómputo que requieren o los grandes grupos, “hay nichos que se pueden aprovechar si se unen esfuerzos para llevar a cabo estas colaboraciones”. La astronomía, agregaron, tiene un carácter transdisciplinario; además de astrofísicos, investigadores y estudiantes de otras áreas (física, química, ingeniería o computación), también pueden aportar al desarrollo y perfeccionamiento de herramientas para efectuar y analizar los resultados de dichos estudios.

Según Héctor Manuel Velázquez, podemos imaginar que una supercomputadora es como un aglomerado de muchas computadoras como las que se tienen en casa, pero todas ellas trabajan de forma colaborativa y durante varias horas y con una conexión mucho más rápida que cualquier internet doméstico.

Emplear estas herramientas permite acelerar descubrimientos, los cuales no se podrían hacer debido a que duran más que la escala de vida humana. “En un futuro se aumentará el realismo y se podrán hacer interpretaciones mucho más precisas”, agregó Velázquez.

Los resultados

Están plasmados en tres nuevos artículos de la colaboración AGORA las llamadas simulaciones Cosmo Run. En ellos se analizó la formación de una galaxia con la masa de la Vía Láctea.

Las simulaciones comparten los mismos supuestos astrofísicos sobre la radiación ultravioleta de fondo, la física del enfriamiento y el calentamiento del gas y la formación de estrellas, pero difieren en la arquitectura del código y en la física de la retroalimentación estelar. Con la ayuda de los nuevos resultados, se determinó que las galaxias de disco, como la Vía Láctea, podrían haber comenzado a formarse temprano en la historia del universo, como se dio a conocer en las recientes observaciones del telescopio espacial James Webb.

Asimismo, descubrieron que el número de galaxias satélite brillantes –aquellas que orbitan alrededor de otras más grandes– encaja con las observaciones, independientemente de la estrategia de simulación utilizada, lo cual disminuye un viejo problema llamado “de los satélites perdidos”, que consiste en la ausencia de una gran población de pequeñas galaxias satélites brillantes en las observaciones, la cual es predicha mediante simulaciones de materia oscura sin la inclusión de gas y estrellas.

Héctor Manuel Velázquez y Octavio Valenzuela Tijerino invitan a que más jóvenes que estén interesados en participar y colaborar en este proyecto se acerquen para buscar ser parte de ello: “Las puertas están abiertas”, ya que con más talento humano se podrá acelerar la obtención de resultados para seguir mejorando las técnicas de observación y entendimiento del universo.

El estudio estuvo dirigido por Ji-hoon Kim en la Universidad Nacional de Seúl, Corea; Joel Primack, Universidad de California Santa Cruz, y Santi Roca-Fàbrega, Universidad de Lund, Suecia.

Se utilizaron supercomputadoras en varios países, entre ellas Miztli en la DGTIC UNAM, Atocatl y Tochtli en el LAMOD-UNAM, así como Perlmutter en el NERSC, HIPAC y XSEDE, en Estados Unidos; CfCA y Oakforest- PACS en Japón.

En la colaboración AGORA participan alrededor 160 investigadores de 60 universidades de todo el mundo. Parte del estudio se ha publicado en The Astrophysical Journal. A continuación, los enlaces a los artículos: https://arxiv.org/abs/2402.06202, https://arxiv.org/abs/2402.05392 y https://arxiv.org/abs/2402.05246